Den økende investeringen i AI-agenter antyder en fremtid med utbredt automatisering, potensielt enda mer transformativ enn den industrielle revolusjonen. Som med enhver teknologisk innovasjon, vil AI-agenter møte problemer i sin utvikling. Kontinuerlig forbedring vil være avgjørende for ansvarlig bruk og for å realisere AI-agenters fulle potensial.

På Consensus Hong Kong intervjuet BeInCrypto Andrei Grachev, Managing Partner i DWF Labs, om de viktigste utfordringene AI-agenter står overfor for å oppnå masseadopsjon og hvordan utbredt bruk kan se ut.

Tradisjonelle teknologisektorer og Web3 omfavner AI

På dette tidspunktet er det trygt å si at adopsjon av kunstig intelligens (AI) snart vil være uunngåelig. Teknologigiganter som Meta, Amazon, Alphabet og Microsoft har allerede kunngjort planer om å investere opptil $ 320 milliarder i AI og datasentre i 2025.

I løpet av sin første uke i embetet kunngjorde USAs president Trump Stargate, et nytt privat joint venture fokusert på utvikling av AI-datasentre. Venturet, som består av OpenAI, Softbank og Oracle, planlegger å bygge opptil 20 store AI-datasentre over hele USA.

Den innledende investeringen er estimert til å være $ 100 milliarder, og utvidelsesplaner kan bringe totalen til $ 500 milliarder innen 2029.

Web3-prosjekter gjør også lignende investeringer i AI. I desember lanserte DWF Labs, et ledende kryptoventurekapitalselskap, et $ 20 millioner AI-agentfond for å akselerere innovasjon innen autonome AI-teknologier.

Tidligere denne måneden kunngjorde NEAR Foundation, som støtter NEAR-protokollen, også sitt eget $ 20 millioner fond fokusert på å skalere utviklingen av fullt autonome og verifiserbare agenter bygget på NEAR-teknologi.

“Historien viser at alt som kan automatiseres vil bli automatisert, og definitivt vil noen forretnings- og hverdagsprosesser bli overtatt av AI-agenter,” fortalte Grachev til BeInCrypto.

Men etter hvert som AI-utviklingen akselererer, blir potensialet for misbruk en økende bekymring.

Ondsinnet bruk av AI-agenter

I Web3 blir AI-agenter allerede raskt mainstream. De tilbyr ulike kapabiliteter, fra markedsanalyse til autonom kryptohandel.

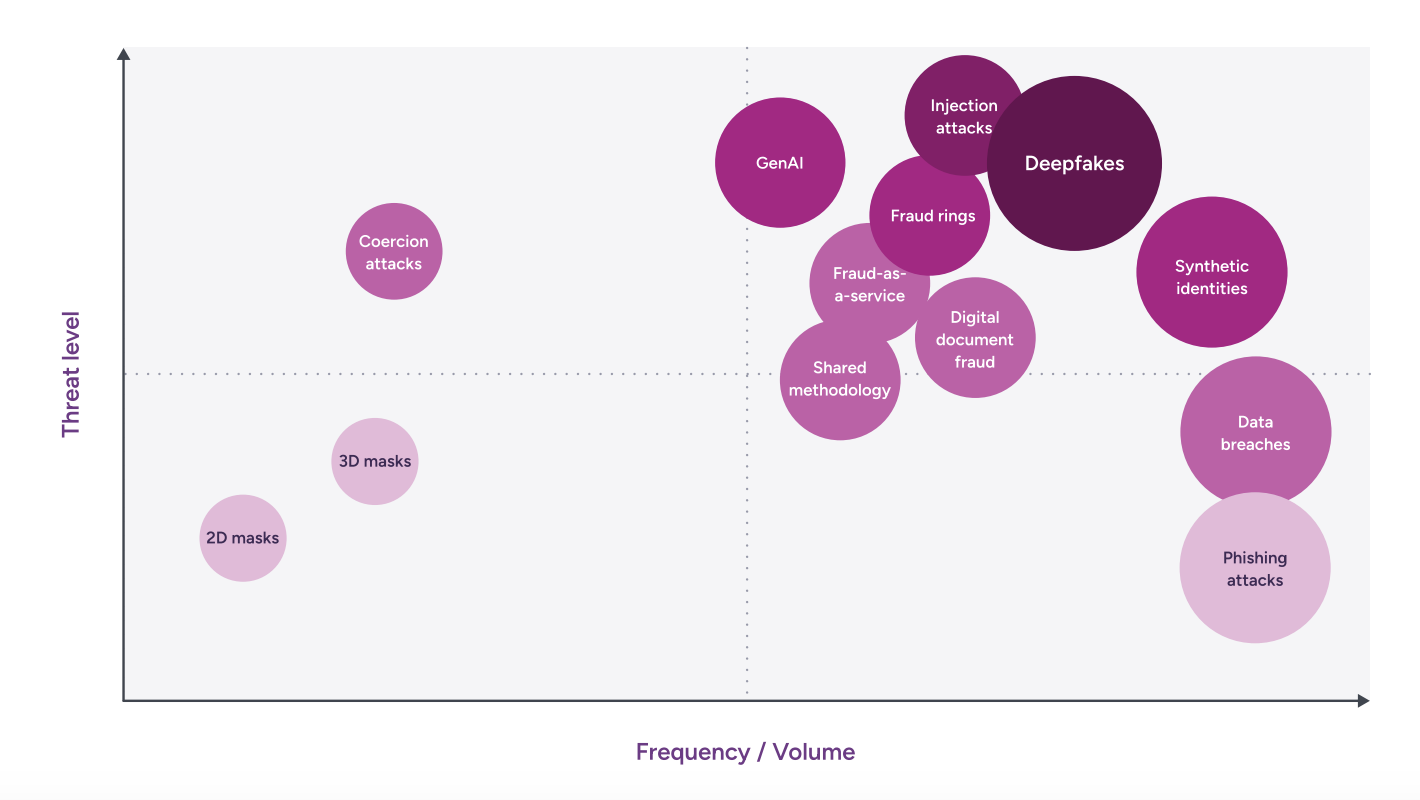

Imidlertid presenterer deres økende integrasjon også kritiske utfordringer. AI-misbruk av ondsinnede aktører er en stor bekymring, og omfatter scenarier fra enkle phishing-kampanjer til sofistikerte løsepengeangrep.

Den utbredte tilgjengeligheten av generativ AI siden slutten av 2022 har fundamentalt endret innholdsskaping samtidig som den tiltrekker seg ondsinnede aktører som søker å utnytte teknologien. Denne demokratiseringen av datakraft har forbedret motstanderens kapabiliteter og potensielt senket terskelen for mindre sofistikerte trusselaktører.

I følge en Entrust rapport, overgår digitale dokumentforfalskninger tilrettelagt av AI-verktøy nå fysiske forfalskninger, med en økning på 244 % fra år til år i 2024. I mellomtiden sto deepfakes for 40 % av all biometrisk svindel.

“Det brukes allerede til svindel. Det brukes til videosamtaler når man feilrepresenterer folk og deres stemmer,” sa Grachev.

Eksempler på denne typen utnyttelse har allerede nådd nyhetsoverskriftene. Tidligere denne måneden ble en finansarbeider i et multinasjonalt selskap i Hong Kong lurt til å autorisere en betaling på $ 25 millioner til svindlere ved bruk av deepfake-teknologi.

Arbeideren deltok i en videosamtale med personer han trodde var kolleger, inkludert selskapets finansdirektør. Til tross for innledende nøling, fortsatte arbeideren med betalingen etter at de andre deltakerne virket og hørtes autentiske ut, ifølge rapporter. Det ble senere oppdaget at alle deltakerne var deepfake-fabrikasjoner.

Fra tidlig adopsjon til mainstream aksept

Grachev mener at slike ondsinnede bruksområder er uunngåelige. Han bemerker at teknologisk utvikling ofte ledsages av innledende feil, som avtar etter hvert som teknologien modnes. Grachev ga to distinkte eksempler for å bevise sitt poeng: de tidlige stadiene av World Wide Web og Bitcoin.

“Vi bør huske at Internett startet med pornosider. Det var som den første Bitcoin, som startet med narkotikahandlere og deretter forbedret seg,” sa han.

Flere rapporter støtter Grachev. De antyder at voksenunderholdningsindustrien spilte en avgjørende rolle i den tidlige adopsjonen og utviklingen av Internett. Utover å tilby en forbrukerbase, banet den vei for teknologier som VHS, videostreaming, virtuell virkelighet og enhver form for kommunikasjon.

Pornografi fungerte som et verktøy for onboarding. Voksenunderholdningsindustrien har historisk sett drevet forbrukeradopsjon av ny teknologi.

Dens tidlige omfavnelse og anvendelse av innovasjoner, spesielt når de med suksess møter publikums behov, fører ofte til bredere mainstream-adopsjon.

“Det startet med moro, men moro onboardet mange mennesker. Deretter kan du bygge noe på dette publikummet,” sa Grachev.

Over tid ble det også innført tiltak for å begrense frekvensen og tilgjengeligheten av voksenunderholdning. Uansett er det fortsatt en av de flere tjenestene Internett tilbyr i dag.

Bitcoins reise fra darknet til forstyrrelse

Utviklingen av Bitcoin speiler nært Internettets tidligste bruksområder. Bitcoins tidlige adopsjon var betydelig assosiert med darknet-markeder og ulovlige aktiviteter, inkludert narkotikahandel, svindel og hvitvasking av penger. Dens pseudonyme natur og enkelheten ved globale pengeoverføringer gjorde den attraktiv for kriminelle.

Til tross for fortsatt bruk i kriminelle aktiviteter, har Bitcoin funnet mange legitime bruksområder. Blokkjede-teknologien som ligger til grunn for kryptovalutaer gir løsninger på virkelige problemer og forstyrrer tradisjonelle finansielle systemer.

Selv om de fortsatt er svært nye industrier, vil kryptovaluta- og blokkjedeapplikasjoner fortsette å utvikle seg. Ifølge Garchev vil det samme skje med gradvis bruk av AI-teknologi. For ham må feil ønskes velkommen for å lære av dem og justere deretter.

“Vi bør alltid huske at svindel skjer først, og så begynner folk å tenke på hvordan man kan forhindre det. Selvfølgelig vil det skje, men det er en normal prosess, det er en læringskurve,” sa Grachev.

Å vite at disse situasjonene vil skje i fremtiden reiser imidlertid også spørsmål om hvem som bør holdes ansvarlig.

Ansvarsbekymringer

Å fastslå ansvar når skade oppstår på grunn av en agents handlinger er et komplekst juridisk og etisk spørsmål. Spørsmålet om hvordan man skal holde AI ansvarlig oppstår uunngåelig.

Kompleksiteten i AI-systemer skaper utfordringer med å fastslå ansvar for skade. Deres “black box”-natur, uforutsigbar oppførsel og kontinuerlige læringsevner gjør det vanskelig å anvende typiske ideer om hvem som har skylden når noe går galt.

Videre kompliserer involveringen av flere parter i AI-utvikling og distribusjon ansvarsbedømmelser, noe som gjør det vanskelig å fastslå skyld for AI-feil.

Ansvar kan ligge hos produsenten for design- eller produksjonsfeil, programvareutvikleren for problemer med koden, eller brukeren for ikke å følge instruksjoner, installere oppdateringer eller opprettholde sikkerhet.

“Jeg tror hele greia er for ny, og jeg tror vi bør kunne lære av det. Vi bør kunne stoppe noen AI-agenter hvis det er nødvendig. Men fra mitt synspunkt, hvis det ikke var noen form for dårlig intensjon å lage det, er ingen ansvarlig for det fordi du er noe virkelig nytt,” sa Grachev til BeInCrypto.

Imidlertid, ifølge ham, må disse situasjonene håndteres nøye for å unngå å påvirke kontinuerlig innovasjon.

“Hvis du skylder på denne entreprenøren, ville det drepe innovasjoner fordi folk ville være redde. Men hvis det fungerer på en dårlig måte, riktig, kan det til slutt fungere. Vi må ha en måte å stoppe det på, lære, forbedre og lære på nytt,” la Grachev til.

Den fine linjen forblir imidlertid syltynn, spesielt i mer ekstreme scenarier.

Å løse tillitsproblemer for ansvarlig AI-adopsjon

En vanlig frykt når man diskuterer fremtiden for kunstig intelligens gjelder situasjoner der AI-agenter blir mer kraftfulle enn mennesker.

“Det er mange filmer om det. Hvis vi snakker om, la oss si, politi eller myndighetskontroller, eller en hær i en slags krig, er selvfølgelig automatisering som en stor skrekk. Noen ting kan automatiseres til et så stort nivå hvor de kan skade mennesker,” sa Grachev.

Når han ble spurt om et slikt scenario kunne skje, sa Grachev at det i teorien kunne. Uansett innrømmet han at han ikke kunne vite hva som ville skje i fremtiden.

Imidlertid er situasjoner som disse emblematiske for de grunnleggende tillitsproblemene mellom mennesker og kunstig intelligens. Grachev sier at den beste måten å nærme seg dette problemet på er ved å eksponere mennesker for bruksområder der AI faktisk kan være nyttig.

“AI kan være vanskelig for folk å tro på. Derfor bør det starte med noe enkelt, fordi tillit til AI-agenten ikke vil bli bygget når noen forklarer at den er pålitelig. Folk bør bli vant til å bruke det. For eksempel, hvis du snakker om krypto, kan du lansere en meme, la oss si på Pump.fun, men hvorfor ikke lansere det med en talemelding? Med AI-agenter, bare send en talemelding som sier ‘vennligst lanser dette og det,’ og det er lansert. Og så ville neste steg være å stole på agenten med noen viktigere beslutninger,” sa han.

Til syvende og sist vil reisen mot utbredt AI-adopsjon utvilsomt være preget av bemerkelsesverdige fremskritt og uforutsette utfordringer.

Å balansere innovasjon med ansvarlig implementering i denne utviklende sektoren vil være avgjørende for å forme en fremtid der AI gagner hele menneskeheten.

Disclaimer

Alle informatie op onze website wordt te goeder trouw en uitsluitend voor algemene informatiedoeleinden gepubliceerd. Elke actie die de lezer onderneemt op basis van de informatie op onze website is strikt op eigen risico.