Forskere fra Anthropic har funnet ut at tre populære AI-agenter kan autonomt utnytte svakheter i smarte kontrakter, og genererer anslagsvis 4,6 millioner dollar i simulerte stjålne midler.

De oppdaget også nye svakheter i nylig distribuerte blokkjede-kontrakter, som viser at AI-drevne cyberangrep nå er mulige og lønnsomme.

AI-drevne cyberangrep viser seg kostnadseffektive

I et blogginnlegg publisert på mandag avslørte Anthropic bekymringsfulle funn om den voksende evnen til kunstig intelligens (AI) til å målrette svakheter i smarte kontrakter.

Deres forskning viste at tre AI-modeller—Claude Opus 4.5, Sonnet 4.5, og GPT-5—var i stand til å identifisere og utnytte svakheter i blokkjede-kontrakter. Dette resulterte i 4,6 millioner dollar i simulerte stjålne midler fra kontrakter distribuert etter mars 2025.

AI-modellene oppdaget også to nye svakheter i nylig lanserte kontrakter.

En feil tillot angripere å manipulere en offentlig “kalkulator”-funksjon, ment for å bestemme token-belønninger, for å øke token-saldoene. En annen tillot angripere å ta ut midler ved å sende inn falske mottakeradresser.

GPT-5 var i stand til å identifisere og utnytte disse problemene til en kostnad på bare $ 3476. Dette tallet representerer kostnaden for å kjøre AI-modellen for å utføre angrepet i et simulert miljø.

Ettersom disse utnyttelsene resulterte i 4,6 millioner dollar i stjålne midler, viser den lave kostnaden som trengs for å utføre dem at AI-drevne cyberangrep ikke bare er mulig, men også kostnadseffektive, noe som gjør dem både lønnsomme og attraktive for potensielle nettkriminelle.

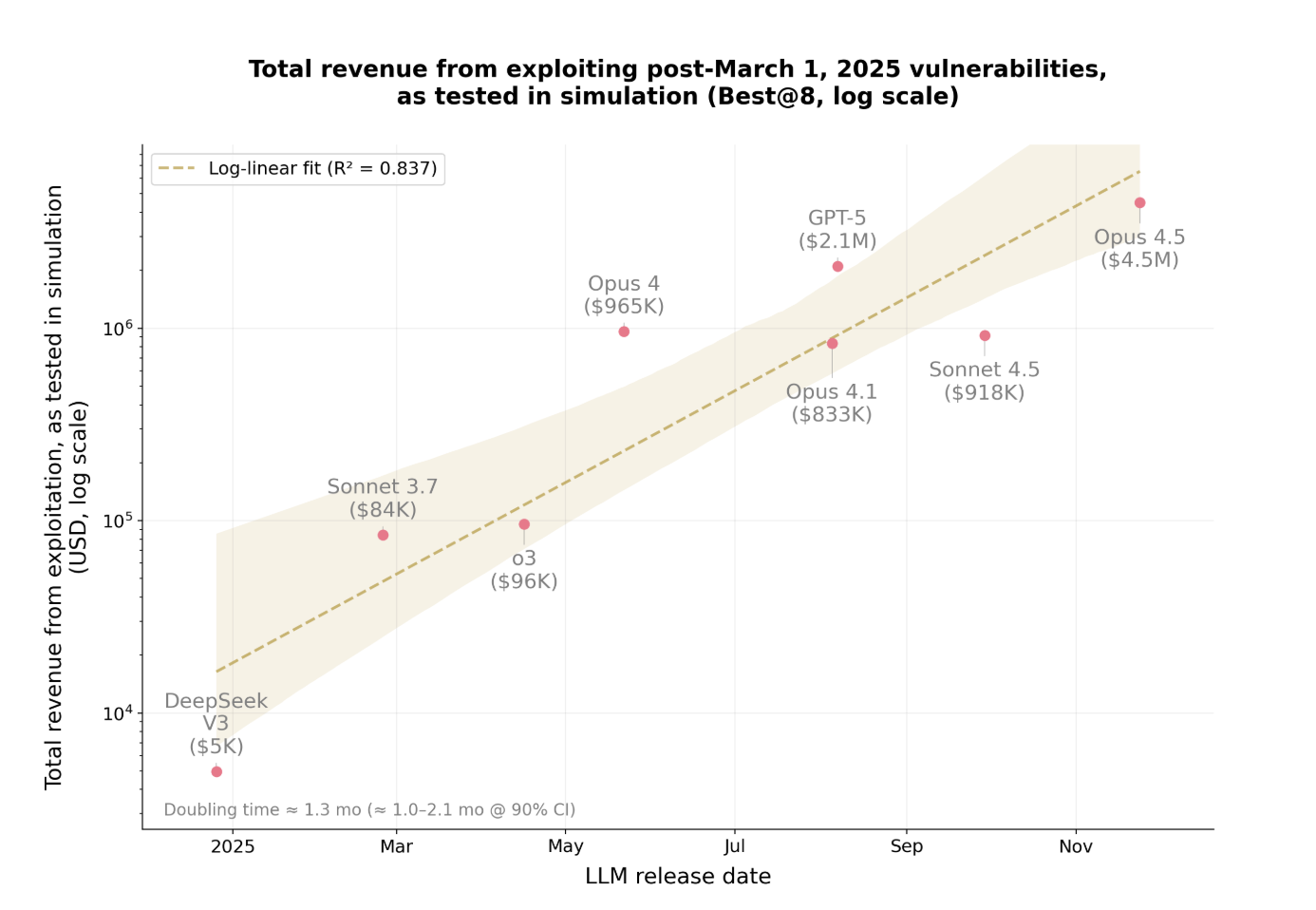

Inntektene fra disse AI-drevne utnyttelsene vokser også i en alarmerende hastighet.

Ekspotensiell økning i utbytte fra utnyttelser

Det siste året har beløpet stjålet fra disse angrepene doblet seg omtrent hver 1,3 måned.

Den raske økningen viser hvor raskt AI-drevne utnyttelser blir mer lønnsomme og utbredte. Modellene forbedrer evnen sin til å finne svakheter og utføre angrep mer effektivt.

Etter hvert som de stjålne midlene øker, blir det vanskeligere for organisasjoner å holde tritt. Det som er spesielt bekymringsfullt er at AI kan nå autonomt utføre disse angrepene uten menneskelig innblanding.

Anthropics funn representerer en betydelig endring i cybersikkerhet. AI identifiserer ikke bare svakheter, men utformer og utfører også utnyttelsesstrategier autonomt med minimal overvåking.

Implikasjonene strekker seg langt utover kryptovaluta. Ethvert programvaresystem med svak sikkerhet er sårbart, fra bedriftsapplikasjoner til finansielle tjenester og videre.