Nvidias Rubin-sjetonger gjør AI til billig infrastruktur. Det er derfor åpne intelligensmarkeder som Bittensor blir viktigere.

Nvidia brukte CES 2026 til å signalisere et stort skifte i hvordan kunstig intelligens skal driftes. Selskapet begynte ikke med forbruker-GPU-er. I stedet introduserte det Rubin, en AI-plattform i rack-skala bygd for å gjøre storskalainferens raskere, billigere og mer effektiv.

Rubin gjør AI til industriell infrastruktur

Nvidias CES-presentasjon viste tydelig at de ikke lenger selger enkeltstående sjetonger. De selger AI-fabrikker.

Rubin er Nvidias neste generasjons datasenter-plattform som følger etter Blackwell. Den kombinerer nye GPU-er, høykapasitets HBM4-minne, spesialtilpassede CPU-er og lynraske sammenkoblinger i ett tett integrert system.

I motsetning til tidligere generasjoner, behandler Rubin hele racket som én databehandlingsenhet. Denne utformingen reduserer databevegelse, forbedrer minnetilgang og kutter kostnaden for å kjøre store modeller.

Som et resultat gjør det at skyleverandører og virksomheter kan kjøre AI med lang kontekst og stor resonneringsevne til langt lavere kostnad per token.

Dette er viktig fordi moderne AI-arbeidslaster ikke lenger ligner én enkelt chatbot. De er i økende grad avhengig av mange små modeller, agenter og spesialiserte tjenester som kaller hverandre i sanntid.

Lavere kostnader endrer hvordan AI bygges

Ved å gjøre inferens billigere og mer skalerbart, muliggjør Rubin en ny type AI-økonomi. Utviklere kan implementere tusenvis av finjusterte modeller i stedet for én stor monolitt.

Virksomheter kan kjøre agentbaserte systemer som bruker flere forskjellige modeller til ulike oppgaver.

Dette skaper imidlertid et nytt problem. Når AI blir modulbasert og rikelig, må noen bestemme hvilken modell som håndterer hver forespørsel. Noen må måle ytelse, håndtere tillit og styre betalinger.

Skyleverandører kan hoste modellene, men de tilbyr ikke nøytrale markedsplasser for dem.

Det er i dette gapet Bittensor passer inn

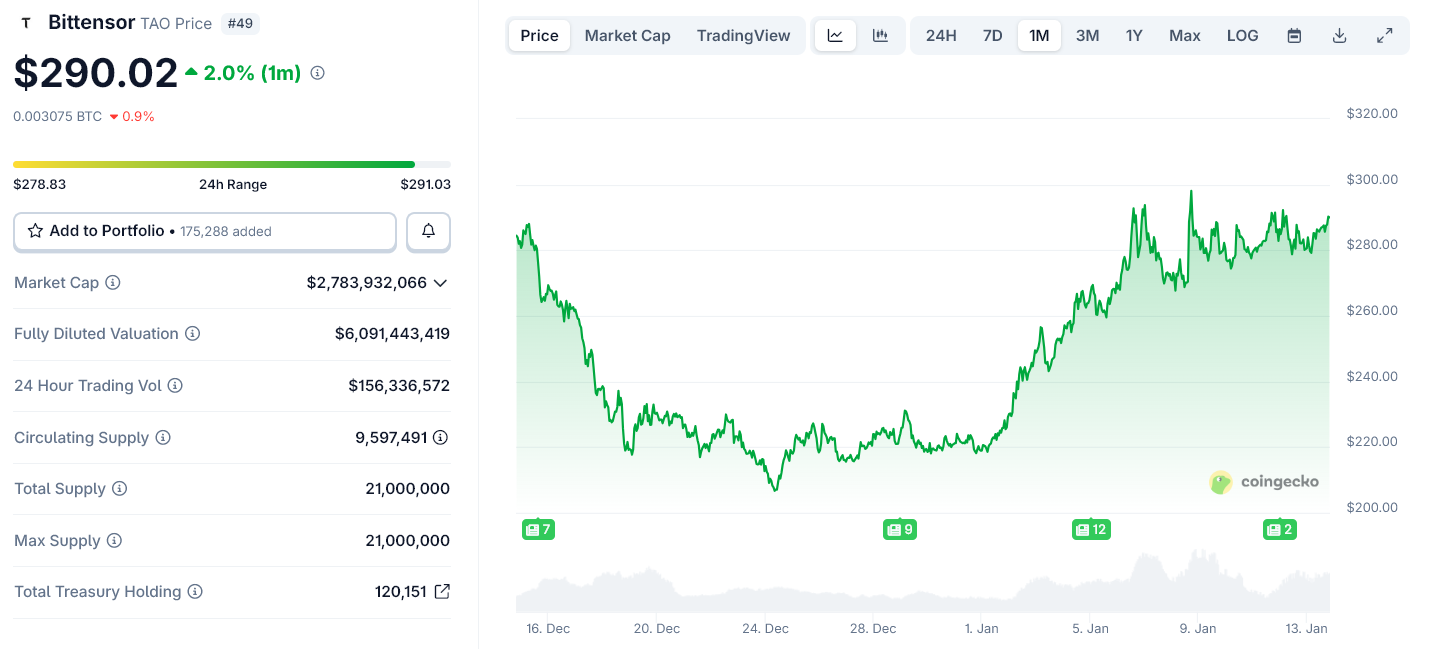

Bittensor selger ikke datakraft. Det driver et desentralisert nettverk der AI-modeller konkurrerer om å levere nyttige svar. Nettverket rangerer disse modellene ved hjelp av on-chain ytelsesdata og betaler dem i sin egen token, TAO.

Hver Bittensor-subnettverk fungerer som et marked for en bestemt type intelligens, for eksempel tekstgenerering, bildebehandling eller dataanalyse. Modeller som presterer bra tjener mer. Modeller som presterer dårlig mister innflytelse.

Denne strukturen blir mer verdifull jo flere modeller som kommer til.

Hvorfor Rubins fra Nvidia gjør Bittensors modell levedyktig

Rubin konkurrerer ikke med Bittensor. Den gjør Bittensors økonomiske modell mulig i stor skala.

Etter hvert som Nvidia senker kostnaden for å kjøre AI, kan flere utviklere og selskaper lansere spesialiserte modeller. Det øker behovet for et nøytralt system for å rangere, velge og betale disse modellene på tvers av skyer og organisasjoner.

Bittensor leverer det koordineringslaget. Det gjør en bølge av AI-tjenester om til et åpent, konkurransedyktig marked.

Nvidia kontrollerer det fysiske laget av AI: sjetonger, minne og nettverk. Rubin styrker denne kontrollen ved å gjøre det billigere og raskere å drifte AI.

Bittensor opererer ett nivå over dette. Det håndterer økonomien i intelligens ved å avgjøre hvilke modeller som blir brukt og belønnet.

Etter hvert som AI beveger seg mot agent-svermer og modulbaserte systemer, blir dette økonomiske laget vanskeligere å sentralisere.

Hva dette betyr fremover

Rubins lansering senere i 2026 vil øke AI-kapasiteten i datasentre og skyer. Det vil føre til vekst i antall modeller og agenter som konkurrerer om reelle arbeidsoppgaver.

Åpne nettverk som Bittensor vil dra nytte av dette skiftet. De erstatter ikke Nvidias infrastruktur. De gir den et marked.

I den forstand svekker ikke Rubin desentralisert AI. Det gir den noe å organisere.